Proviamo FACEWARE, un software di Mocap markerless compatibile con le piattaforme Unity e Unreal.

Usare in ambito “domestico” Mocap facciale oggi è sempre più comune grazie alla disponibilità di prodotti software accessibili e basati su algoritmi markeless affidabili.

L’utilizzo di tecniche di tracking markless, solleva numerose problematiche di carattere tecnico-implementativo a causa delle numerose variabili (luce, ambiente, conformazione del volto, pattern recognize, ecc.) e delle difficoltà nell’interpretare movimenti muscolari interni (come la mascella).

La ricerca scientifica in tale ambito sta facendo passi da gigante, grazie anche all’affinamento degli algoritmi di face-recognize (utilizzati oggi all’interno dei dispositivi mobile), all’integrazione di processi AI e alla potenza di calcolo sempre maggiore presente nei nostri computer domestici.

Alcuni dei più moderni approcci in tale ambito, fa uso di dataset di ricognizioni facciali con marcatori usati come riferimento per l’implementazione di algoritmi di mappatura non-lineare delle pelle, risalendo così a “pose” di riferimento.

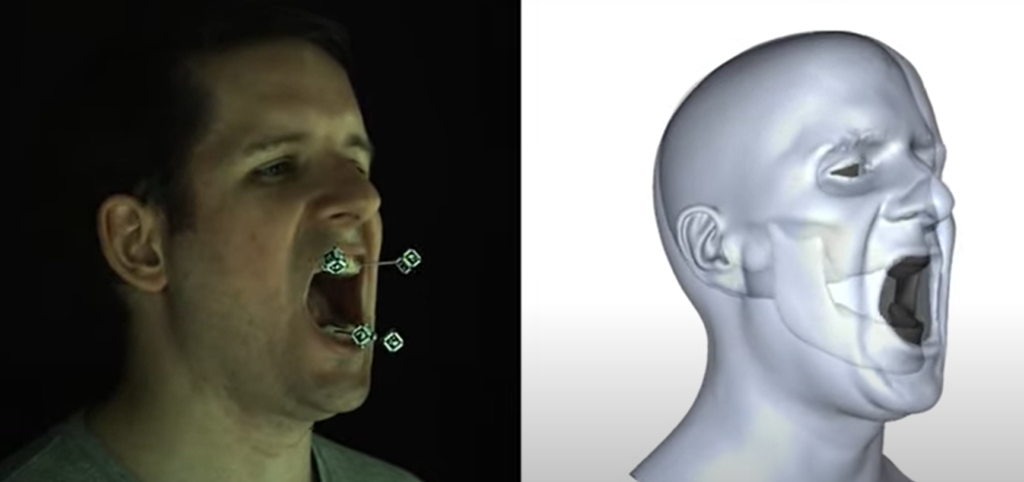

La creazione di questi archivi, ovviamente, implica un impegno notevole al fine di ricostruire un dominio sufficiente per la ricognizione delle movimenti (si consideri che alcuni lavori di ricerca hanno addirittura costretto l’utilizzo di marker applicati sui denti per un più preciso tracciamento dei movimenti mascellari di riferimento).

Rig for Jaw Animation. ACM Transactions on Graphics 37, 4 (2018), 59:1—-59:12.

https://doi.org/10.1145/3197517.3201382

L’applicazione di queste tecniche trova applicazione in vari ambiti, da quello medico-scientifico (per l’identificazione e l’individuazione di deformazioni posturali e/o muscolari) all’ambito rappresentativo (ad esempio cinematografico) dove permette di creare sincronismo espressivo fra attori e personaggi digitali, facilitando la creazione di “alterego” virtuali con cui interagire in ambiente VR anche da remoto.

L’utilizzo di “rig” virtuali e morph-pose digitali, stanno portando a risultati sempre più affidabili anche in contesti low-budget, con l’utilizzo di camere di media risoluzione in ambienti luminosi eterogenei.

Proviamo Faceware studio

Fra i tanti software oggi disponibili, ho voluto provato FACEWARE STUDIO, scaricabile in TRIAL dal sito https://facewaretech.com/software/studio/

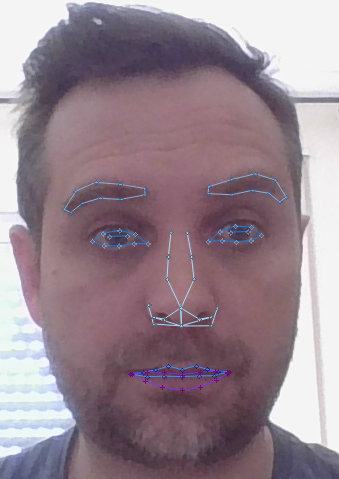

Questo programma consente l’analisi in tempo reale delle deformazioni facciali senza l’utilizzo di marker e con una semplice camera (anche quella integrata nel notebook), dopo una rapidissima calibrazione iniziale.

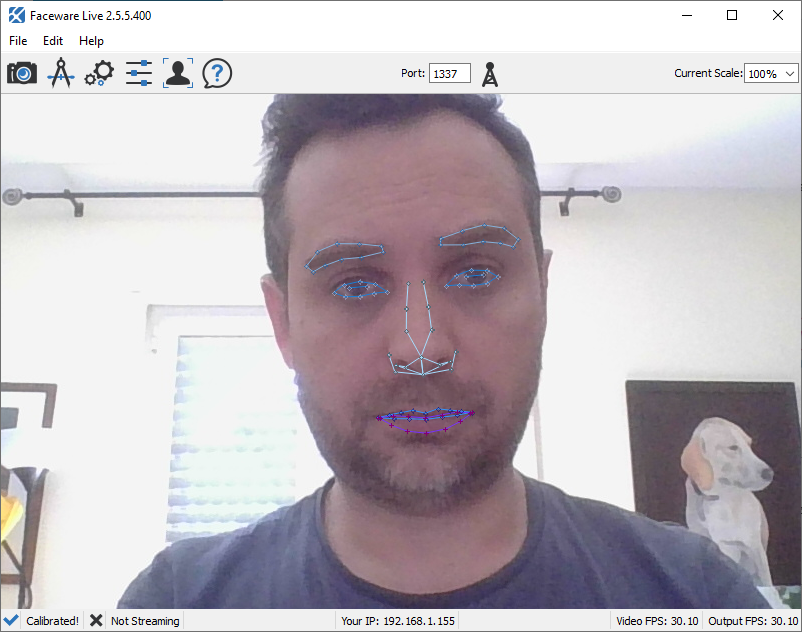

Il tracking, funziona riconoscendo e “ancorando” lo spostamento di alcune parti del volto (sopracciglia, occhi, bocca, palpebre, naso) e la roto-traslazione dell’intero viso, offrendo quindi una sufficiente programmabilità in ambito simulativo anche in condizioni di luminosità non ottimale (nel mio test ho cercato di provarlo in un ambiente domestico, con illuminazione e background non ottimizzati).

L’interpretazione del movimento mascellare, viene ottimizzato con l’ausilio di algoritmi di deep learning e messo a disposizione di funzionalità di re-targeting per pipeline non-realtime (utili per produzioni di video/animazioni/videogiochi).

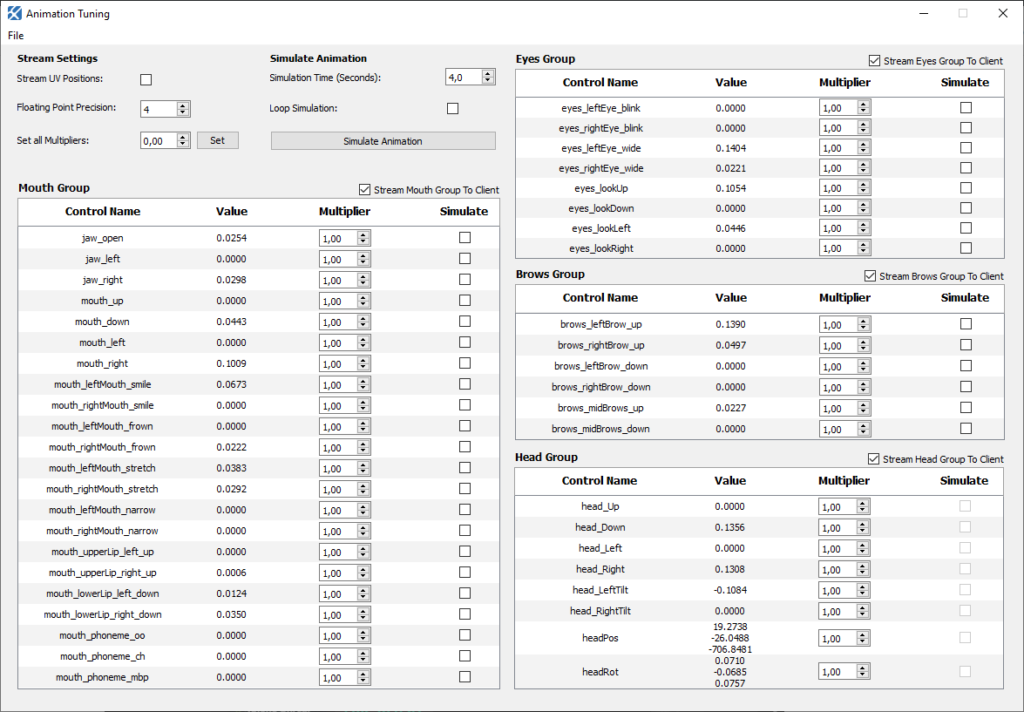

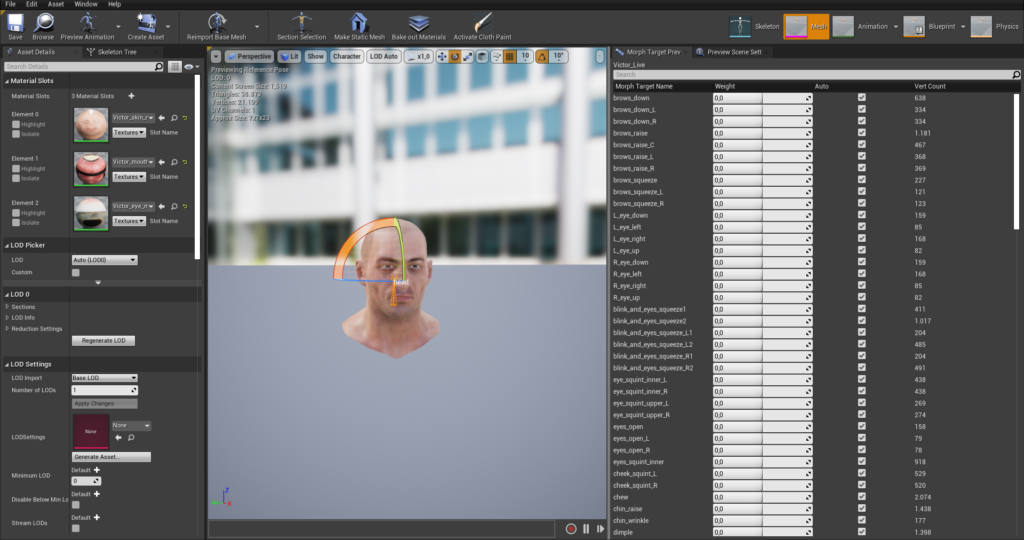

Anche il tracciamento in tempo reale può essere ottimizzato e ricalibrato tramite parametri di tuning disponibili in fase di capture. Ovviamente a questi si aggiunge sempre la possibilità di un’ulteriore finitura in ambito di programmazione direttamente all’interno delle piattaforme di sviluppo con i parametri messi a disposizione dalle classi-oggetto.

Il collegamento all’interno di ambienti di sviluppo gaming (come Unity ed Unreal) è garantito dall’utilizzo di un plugin, sviluppato dalla software-house Glassbox. Qui proviamo quello per Unreal, denominato LIVE CLIENT, scaricabile in DEMO da questo sito https://glassboxtech.com/products/live-client#downloads

Installazione e configurazione

Andando sul sito https://glassboxtech.com/products/live-client#downloads possiamo selezionare la versione del plugin che vogliamo scaricare in base alla versione di Unreal che utilizziamo.

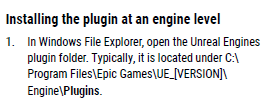

Dopo aver scaricato il plugin LIVE CLIENT, esplodiamo il file ZIP ed installiamo la cartella scaricata all’interno del percorso PLUGIN di Unreal

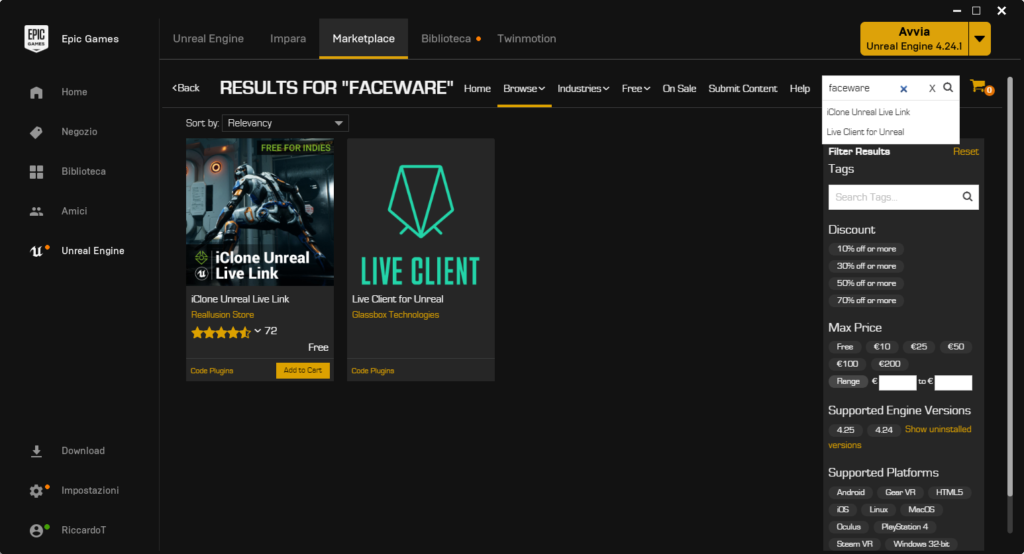

In alternativa, possiamo andare direttamente dal Market Store a scaricare il client. Ad oggi, sul client è presente solo il plugin per la versione 4.23 di Unreal.

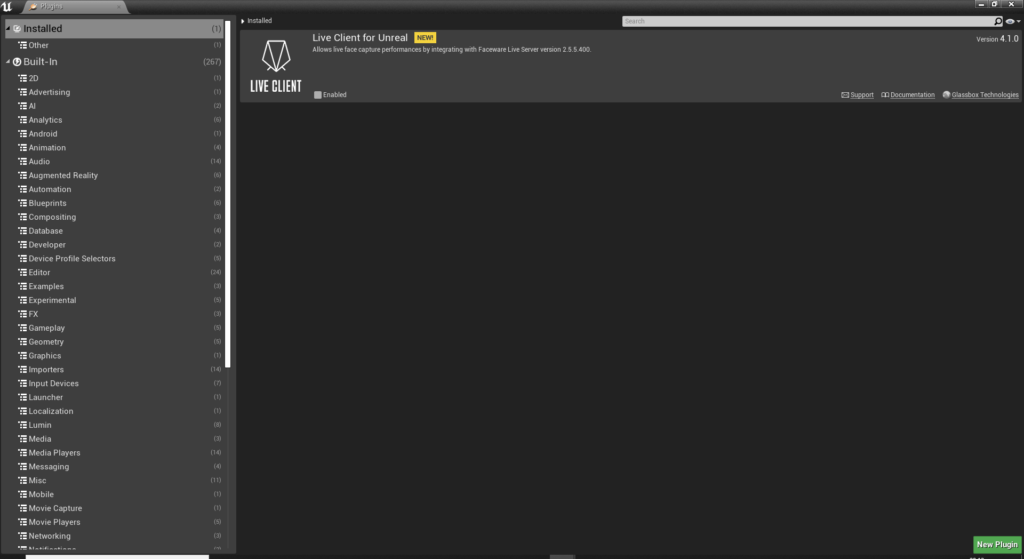

Dopo averlo copiato, creiamo un nuovo progetto con Unreal e, dal menù superiore EDIT->PLUGIN, attiviamo il plugin LIVE CIENT e riavviamo Unreal.

Se si vuole provare subito le funzionalità di tracking, è possibile scaricare, oltre al plugin, anche il relativo progetto DEMO già preconfigurato e quindi pronto all’utilizzo.

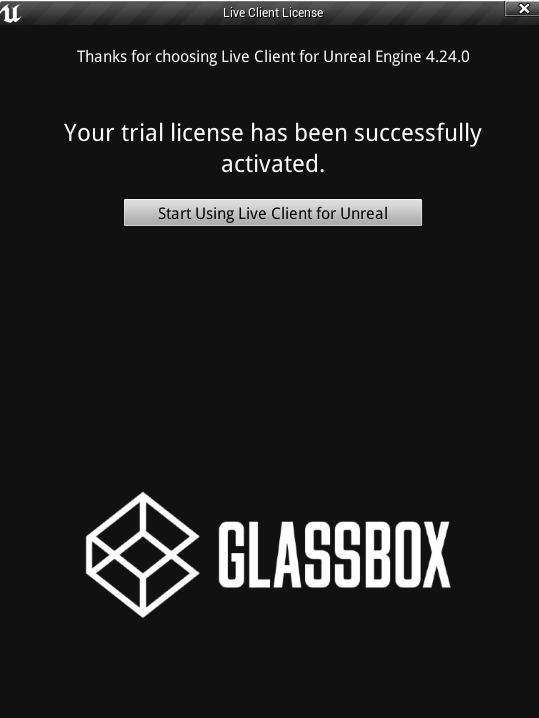

Al riavvio del progetto, Unreal ci chiederà di attivare il plugin tramite una registrazione online. Se decidiamo di attivare la versione DEMO, clicchiamo su TRY, compiliamo il form online e ricopiamo il numero “activation key” nel campo della finestra.

Ora possiamo scaricare il software che si occupa di tracciare le nostre espressioni in tempo reale.

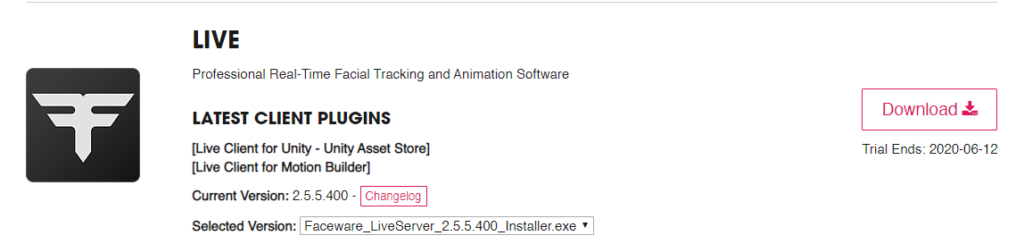

Andando sul sito https://facewaretech.odoo.com/downloads possiamo scegliere quale modulo del software vogliamo provare.

Per effettuare una simulazione possiamo scegliere il modulo LIVE scaricandolo dall’elenco.

Siamo quindi pronti per iniziare, abbiamo tutti gli strumenti per far partire il tracking.

Avviamo il software LIVESERVER appena scaricato ed impostiamo nella finestra principale la porta di comunicazione che vogliamo utilizzare per trasmettere i dati di tracciamento.

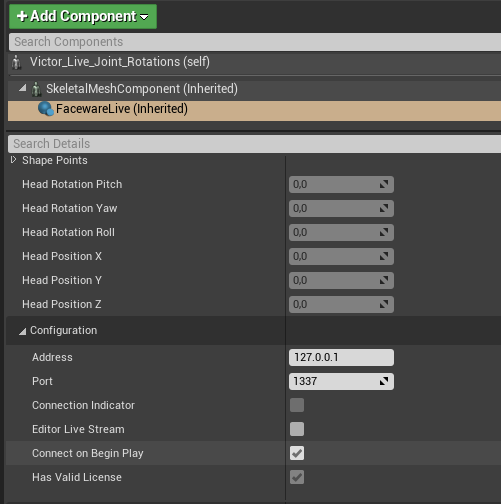

Se lasciamo il valore di default 1337 possiamo utilizzare facilmente il progetto DEMO di Unreal già pre-configurato scaricato prima.

Calibriamo l’immagine e clicchiamo sul pulsante a forma di antenna (accanto al numero porta) per iniziare lo streaming verso il plugin; in questo modo il software inizierà a trasmettere le informazioni analizzate nel capture verso i software in “ascolto” sulla porta definita prima.

Se decidiamo di utilizzare il progetto DEMO è sufficiente configurare l’indirizzo e porta di collegamento con il LIVE tracking e premere PLAY nella simulazione.

Per lo sviluppo di nostri progetti personalizzati, all’interno di Unreal abbiamo la possibilità di richiamare il morph tramite il componente Faceware Live che può essere collegato in blueprint e configurato tramite le proprietà dell’Actor.

La possibilità di realizzare animazioni sincronizzate in realtime o di registrare e rielaborare (tramite l’applicativo STUDIO) il motion capture registrato, rendono questo software uno strumento utile per effettuare simulazioni umane nell’ambito di scenari digitali, anche immersivi, in cui possiamo ipotizzare la creazione di avatar sincronizzati (anche in remoto) con operatori preposti.