Siamo ormai abituati agli annunci dirompenti del team Epic sulle nuove incredibili integrazioni all’interno del famoso ambiente di sviluppo Unreal Engine.

Una delle discipline in cui gli sviluppatori della casa americana stanno investendo da diverso tempo è l’integrazione del rendering in realtime in fase di produzione visiva.

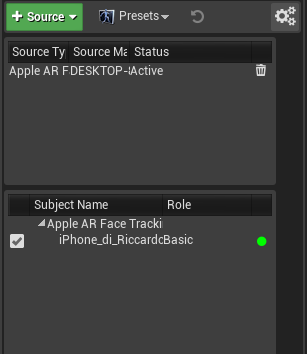

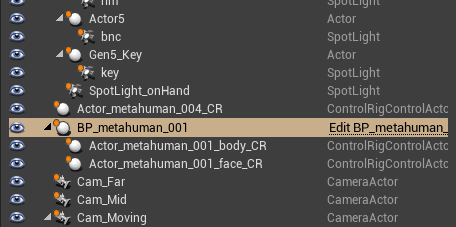

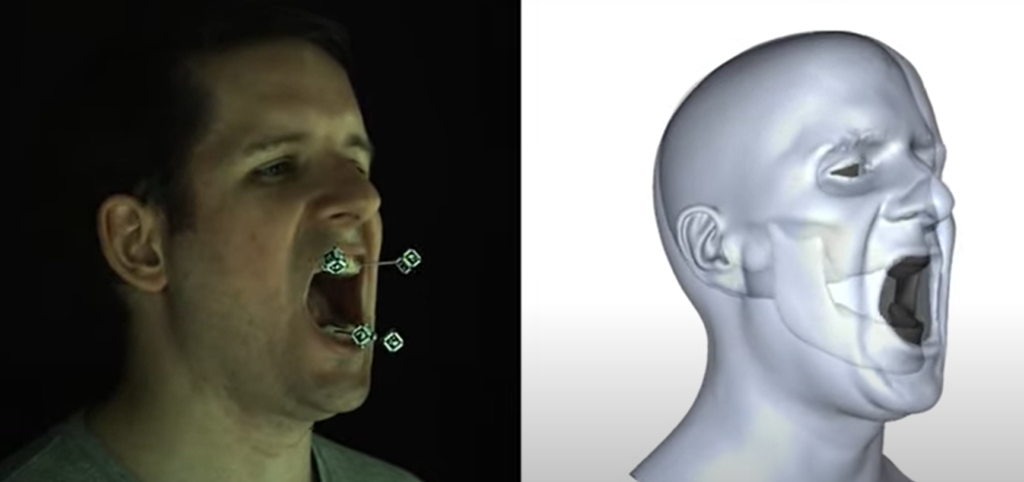

Ne è un esempio l’integrazione del mo-cap in tempo reale o del tracking della camera da ripresa.

Le funzioni in-camera VFX

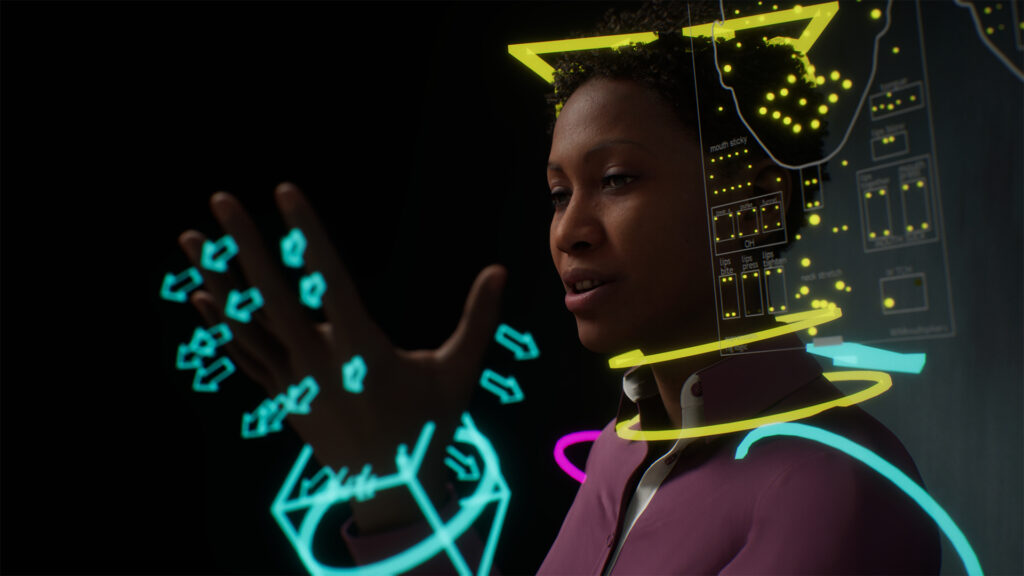

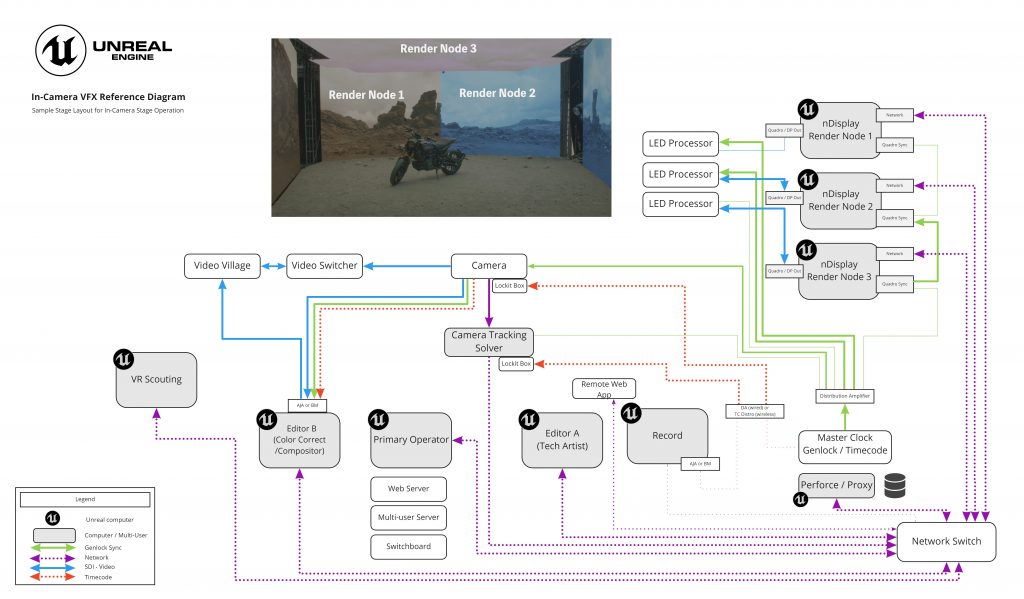

Immaginiamo di avere a disposizioni un set di ripresa con un background costituito da pannelli LED (come tanti monitor) collegati tra loro che proiettano un’immagine sincronizzata con la scena virtuale presente all’interno di un progetto di Unreal Engine.

La camera di ripresa presente fisicamente all’interno dello stage, viene collegata ad un sistema di live tracking in modo che i suoi movimenti vengano tracciati e sincronizzati con la camera virtuale presente all’interno del progetto UE4 e visualizzata on-stage; in questo modo, la scena visualizzata sui display in background risulta perfettamente calibrata con la ripresa live simulando un inner-frustum calibrato con il FOV della camera

I display esterni al campo visivo, proietteranno l’ambiente virtuale circostante, in un outer-frustum che collaborerà ad una illuminazione (e riflessione) realistica dei soggetti e dei materiali ripresi.

A questo, si aggiunge la possibilità di inserire effetti visivi all’interno della ripresa virtuale, ritrovandoli immediatamente in off-axis projection, con un perfetto allineamento con la scena reale.

Grazie ai sistemi nDisplay, Live Link, Multi-User Editing, e Web Remote Control offerti da Unreal, l’utente è in grado di creare un vero e proprio set digitale virtuale.

Shooting virtuale

Ed è proprio su questa linea di sviluppo che i programmatori di Epic in collaborazione con lo studio di produzione Bullit, hanno sperimentato una piccola produzione cinematografica in virtual-real time, integrando le nuove tecnologie presenti nella versione 4.27 di Unreal Engine.

All’interno degli studi californiani della NantStudios, si è sperimentato un workflow innovativo, in cui pre-produzione, shooting e post-produzione si sono integrati all’interno di un ambiente totalmente virtualizzabile e programmabile in tempo reale.

Sfruttando la potenza di calcolo di due GPU NVIDIA Quadro A6000 ed un sistema di proiezione LED dello stage virtuale, il team è riuscito a chiudere questa produzione in soli 4 giorni, sfruttando i nuovi tools di controllo e simulazione in-camera offerti dall’ambiente grafico Unreal.

La possibilità di riconfigurare in pochissimo tempo una scena, simulandone configurazioni ambientali ed illuminazione, ha portato ad una notevole diminuzione dei tempi di produzione con, ovviamente, conseguente risparmio economico.

Inoltre, la possibilità di provare nuove configurazioni in realtime, ha permesso un approccio più creativo e spontaneo, facilitando la sperimentazione di nuovi setup, consentendo al regista di valutarne immediatamente la resa.

Questo nuovo paradigma di produzione porta con sè anche una rivoluzione nei flussi di lavoro normalmente configurati in una produzione; riunire sul set, durante le riprese, tutti i teams coinvolti normalmente nelle fasi di pre-produzione e post-produzione, porta ad una collaborare in tempo reale sulla scena in fase di shooting, riducendo eventuali incoerenze che normalmente possono verificarsi in fase di lavorazione non simultanea.

Un innovativo modo di concepire la produzione visiva troverà presto integrazioni sempre più diffuse nei vari ambienti di sviluppo, avvicinando settori e professionalità che normalmente sono separati in comparti differenti della computer grafica.

Per approfondire: visita il sito UnrealEngine