All’annuncio della nuova piattaforma di creazione e rigging MetaHuman, Epic ha deciso di anticipare la distribuzione della parte Creator con un progetto demo in Unreal in cui è possibile trovare due personaggi già realizzati.

Ho provato a configurare FaceLink per tracciare il mio volto e associarlo ai personaggi MetaHuman presenti.

Requisiti:

- Windows 10, build 1902 or sup con supporto a DirectX 12

- Scheda video NVIDIA con supporto al Raytracing in realtime

- Unreal Engine 4.26.1 o sup.

- Telefono IPhone X o sup.

- App FaceLink

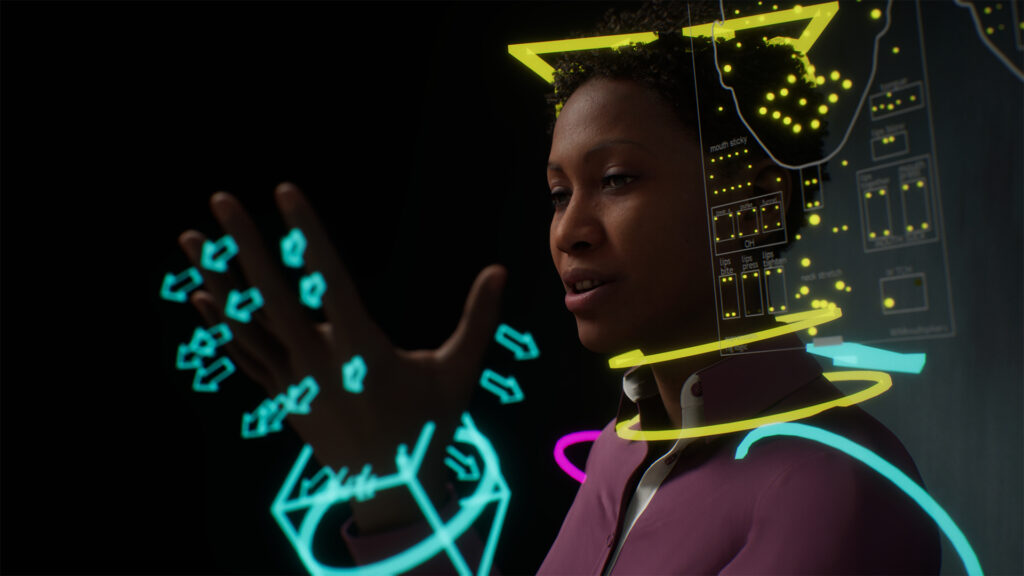

MetaHuman è una nuova piattaforma cloud creata che permette la creazione parametrica di personaggi e il loro successivo RIG, rendendoli pronti per essere utilizzati all’interno dell’ambiente di sviluppo Unreal Engine.

L’utilizzo dell’app, verrà gestita tramite un collegamento web basato sul protocollo Unreal Engine Pixel Streaming e consentirà la creazione di nuovi personaggi tramite la parametrizzazione dei tratti somatici che andranno a scolpire la mesh tridimensionale del volto.

In questo modo, si potrà osservare in tempo reale la modifica che tali impostazioni portano al personaggio.

Gli utenti saranno in grado di applicare stili di capelli, utilizzare campionari di abbigliamento preconfigurato e 18 tipologie di normotipo corporali.

Inoltre, il Creator gestirà in modo automatica la generazione dei vari LOD variabile in base alle componenti (ad esempio il volto supporto fino a 8 LOD mentre il corpo 4 LOD configurati tramite il componente LOD sync di UE4).

Quando terminato l’asset, si potrà scaricare tramite Quixel Bridge, il tutto già completamente riggato, con LOD già definiti e pronto all’eventuale motion capture in Unreal Engine.

Sarà possibile anche utilizzare i singoli file generati in formato Maya.

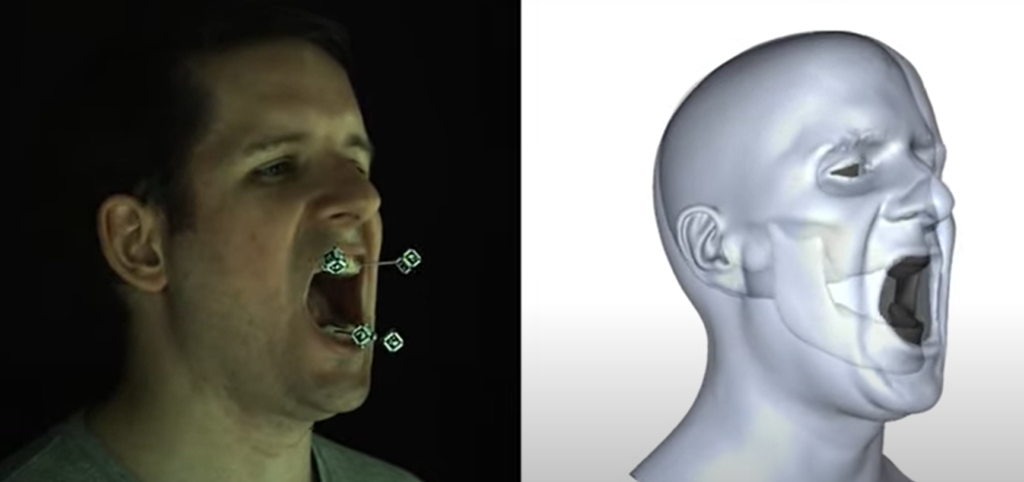

Attualmente il face tracking è supportato solo tramite l’app FaceLink, ma Epic promette una prossima integrazione con Faceware, JALI Inc., Speech Graphics, Dynamixyz, DI4D, Digital Domain, and Cubic Motion, oltre ovviamente alla possibilità di registrazione manuale tramite keyframes.

Maneggiando un po’ il progetto DEMO, devo ammettere che la particolare capacità di deformazione delle mesh e l’ottima configurazione delle texture, rende il risultato veramente fenomenale, soprattutto se si pensa al risparmio di tempo che tale elaborazione, con relative pesature, accompagnano le attività di creazione e riggin dei personaggi all’interno dei software 3D.

Visto che ad oggi, l’APP di creazione non è ancora utilizzabile, mi sono concentrato sulla configurazione face tracking tramite l’app FaceLink.

FaceLink

La configurazione dell’App è semplicissima.

E’ sufficiente installarla ed avviarla abilitando nelle impostazioni (icona a forma di rotellina) la voce STREAM HEAD ROTATION.

Infine, sempre nelle impostazioni, cliccando sulla voce LIVE LINK possiamo accedere alle impostazioni in cui inserire l’indirizzo IP del computer sul quale è avviato Unreal Engine.

Ovviamente il computer deve condividere la stessa rete Wi-Fi del cellulare.

Per approfondire…

Se vuoi approfondire la tematica del FaceTracking markerless, puoi leggere questo mio articolo

Configurazione in Unreal Engine

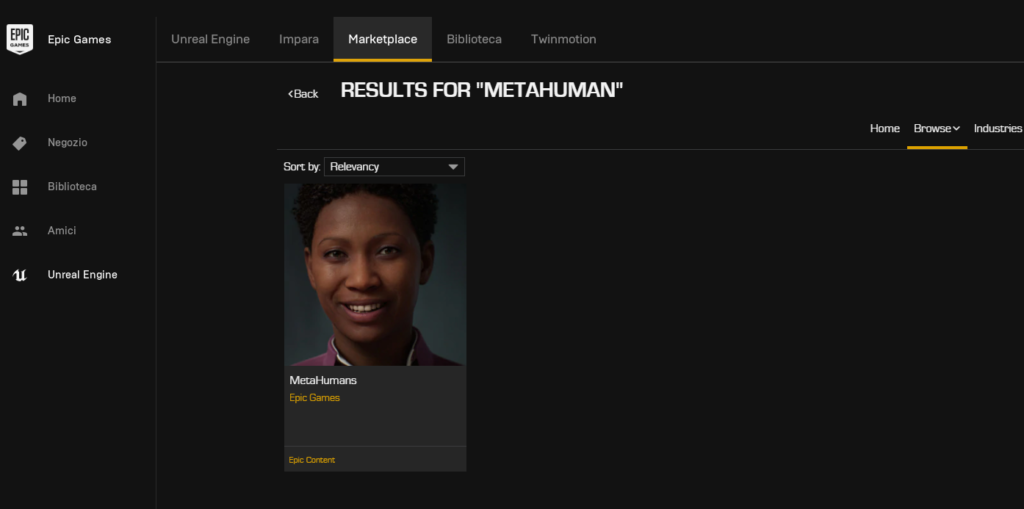

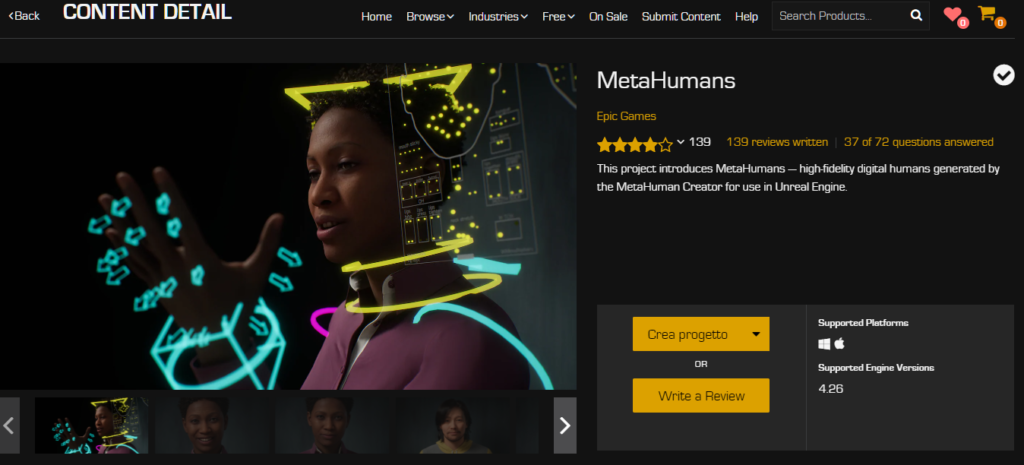

Apriamo Unreal Engine, accertiamoci di avere l’ultima versione dell’Engine installato e successivamente cerchiamo nel MARKETPLACE il progetto MetaHuman, procedendo con l’installazione.

Dopo averlo installato, clicchiamo sul pulsante CREA PROGETTO, scegliamo la posizione sul nostro computer nella quale creare il nuovo progetto UE4 basato sul template MetaHumans.

A questo punto possiamo aprire il progetto appena creato e attendere qualche minuto.

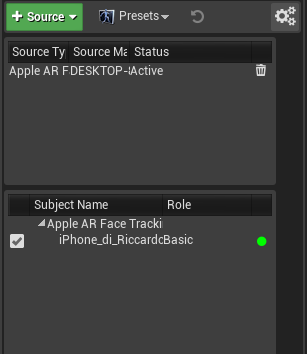

Una volta aperto Unreal, dobbiamo accedere alla finestra FaceLink (se non è visibile la possiamo abilitare dal menù Windows->FaceLink.

Se a questo punto attiviamo l’app FACELINK sul cellulare, dovremmo vedere apparire il nostro ID all’interno dell’elenco delle sorgenti.

Questo significa che Unreal sta ricevendo il flusso di capturing dal nostro cellulare (ma non sa ancora a cosa attribuirlo).

In caso non compaia il nostro ID, verificare le impostazioni di firewall o antivirus presenti nel computer.

Per prima cosa, andiamo a cancellare l’oggetto METASHAPESAMPLE_SEQUENCE. Si tratta di una sequenza video dimostrativa che parte appena mandiamo in PLAY la scena.

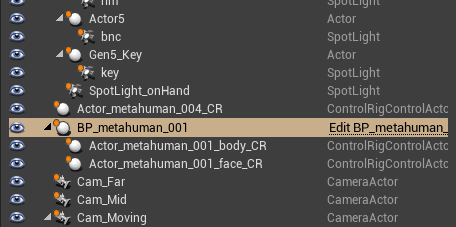

Dopodiché, cerchiamo l’oggetto BP_metahuman_001 che identifica il blueprint associato al personaggio donna della nostra scena (si consideri che all’interno della scena, dietro un “muro” presente alle spalle del personaggio donna, si nasconde un personaggio uomo).

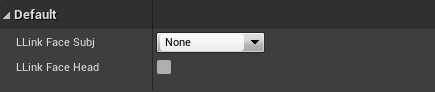

Nelle proprietà del componente troviamo la voce di configurazione di FaceLink. Possiamo impostare l’ID del nostro cellulare e attiviamo la voce LLINK FACE HEAD.

A questo punto possiamo attivare un PLAY SIMULATIVO (attivabile anche tramite la combinazione di tasti ALT+S) e vedremo il personaggio interpretare le nostre smorfie.

Devo dire che la facilità di configurazione del face tracking e la morbidezza espressiva dei personaggi mi ha impressionato positivamente. Qualche limite sul tracciamento con facelink lo attribuisco alla parametrizzazione standard utilizzata nel personaggio e alla tecnologia markerless che introduce inevitabilmente qualche imprecisione.

Sicuramente c’è da attendere la parte Creator per poter completare la valutazione di questa nuova tecnologia ma, comunque, dobbiamo ammettere la semplificazione verso la quale si stanno spingendo i software di rigging che, salvo esigenze particolari, diventano accessibili ai più giovani progettisti 3D.

Per approfondire:

https://www.unrealengine.com/en-US/digital-humans