In questo momento di transizione digitale, in cui il dato diventa informazione, anche la filiera di progettazione e gestione del costruito si sta evolvendo in un nuovo paradigma fondato sul BIM (Building Information Modelling) in cui gli elementi ingegneristici si trasformano in contenitori, classi di oggetti e proprietà informative.

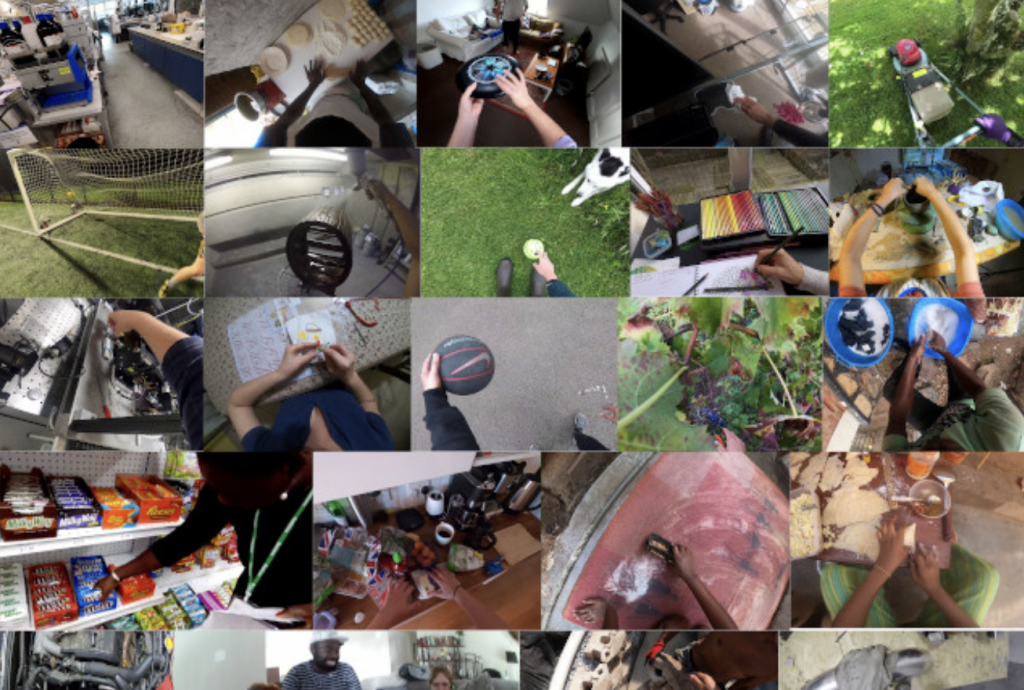

Ego4D, dataset video in soggettiva

Chi studia le applicazioni di intelligenza artificiale, e più in particolare di computer vision, sa bene che uno dei limiti più importanti nella definizione e apprendimento dei modelli è la disponibilità di dataset normalizzati su cui effettuare la fase di apprendimento e testing.<!–more–>

Per questa ragione, in questo ultimo periodo, molti enti di ricerca si stanno adoperando per realizzare e mettere a disposizione del mondo scientifico tali raccolte, organizzandole su base tematica o disciplinare.

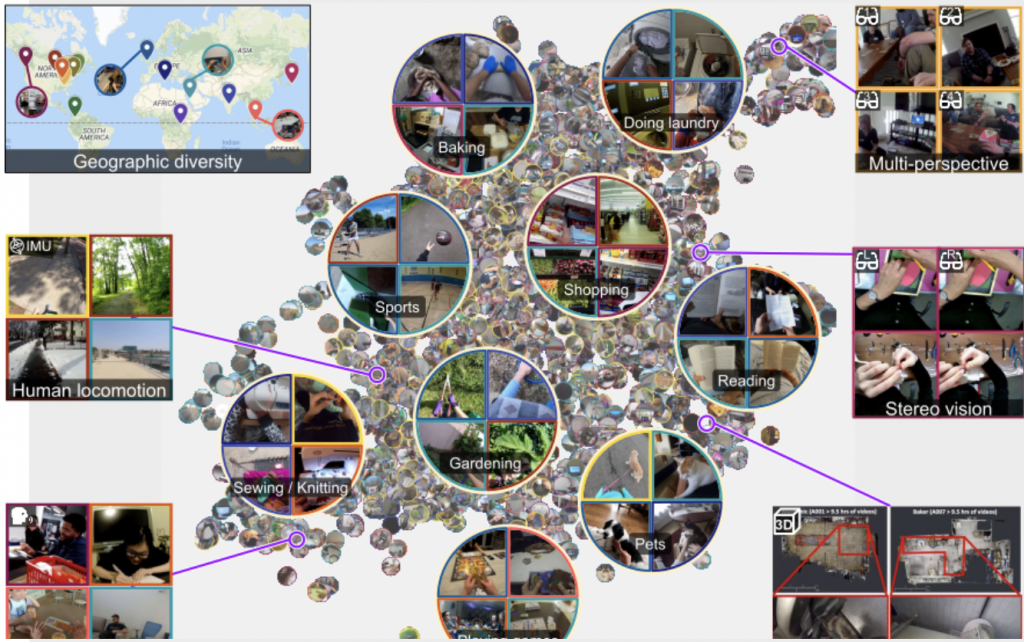

In questo contesto, è stato presentato Ego4D (Egocentric 4D Live Perception), un progetto sviluppato da Facebook insieme ad un consorzio di università internazionali, nato dalla volontà di raccogliere registrazioni video in soggettiva durante le comuni attività giornaliere.

Cosa rende originale Ego4D ?

La scelta di questo POV (point of view) nasce dal fatto che attualmente gran parte dei dataset disponibili è composto da fotografie o video riprese da punti di vista esterni al soggetto che compie l’azione, offrendo agli algoritmi la possibilità di distinguere con maggiore facilità gli elementi costituivi ed il tracking dei soggetti coinvolti.

Nei video in soggettiva, invece, la descrizione visiva di una scena o di una azione cambia totalmente, portando limitazioni e problematiche che attualmente non possono essere affrontate a causa proprio della scarsità di dataset di training.

Una delle novità di questo progetto è proprio la scelta del punto di ripresa.

Infatti, a differenza di quanto avviene normalmente con altre tipologie di raccolte video, in questo caso le registrazioni sono avvenute mediante camere indossabili, posizionate in modo da registrare secondo il punto di vista del soggetto, permettendo così di addestrare futuri modelli AI che possono coadiuvare attività umane mediante sensori “egocentrici”, capaci cioè di percepire la scena dal punto di vista dell’operatore.

Il progetto ha coinvolto oltre 850 partecipanti distribuiti in nove paesi, tra cui l’Italia ,con l’Università di Catania, preservando una eterogeneità di scenari e attività, oltre ovviamente garantendo la privacy dei soggetti ripresi.

I contesti registrati, come detto in precedenza, riguardano attività quotidiane personali (ad esempio cucinare, fare shopping, disegnare, ecc.) e professionali (es. elettricisti, muratori, cuochi, ecc.).

Tale scelta è stata motivata dalla volontà di rendere eterogeneo l’ambiente in cui si svolgono tali azioni, consentendo così che future applicazioni possano essere facilmente predisposte indipendentemente dal contesto in cui si svolgono.

A partire dal mese di novembre 2021, il database contenente oltre 3.000 ore di video sarà reso disponibile alla comunità scientifica.

I benchmark di Ego4D

Oltre alla creazione della raccolta video, il progetto Ego4D si pone l’obiettivo di verificare 5 benchmark applicativi riguardanti i temi: interazione sociale, interazione mano-oggetto, diarizzazione audiovisiva, memoria episodica e previsione.

Questi obiettivi, rappresentano in modo chiaro la direzione della ricerca applicativa:

- la possibilità di riconoscere un’azione svolta nel passato, in modo da riconoscere e “ricordare” avvenimenti e azioni svolte

- comprendere comportamenti e abitudini, in modo da simulare previsioni sociali o sistemiche;

- apprendere i movimenti e i meccanismi che l’uomo usa per interagire con gli oggetti, in modo da interpretare gesture da integrare nei vari algoritmi;

- consentire l’utilizzo del suono in soggettiva per migliorare l’apprendimento dell’ambiente e delle azioni che si svolgono;

- studiare e comprendere l’interazione interpersonale.

L’obiettivo ultimo che si pone il progetto è quello di integrare e migliorare le potenzialità e l’integrazione della computer vision all’interno dei sistemi di automazione

Per approfondire:

Articolo

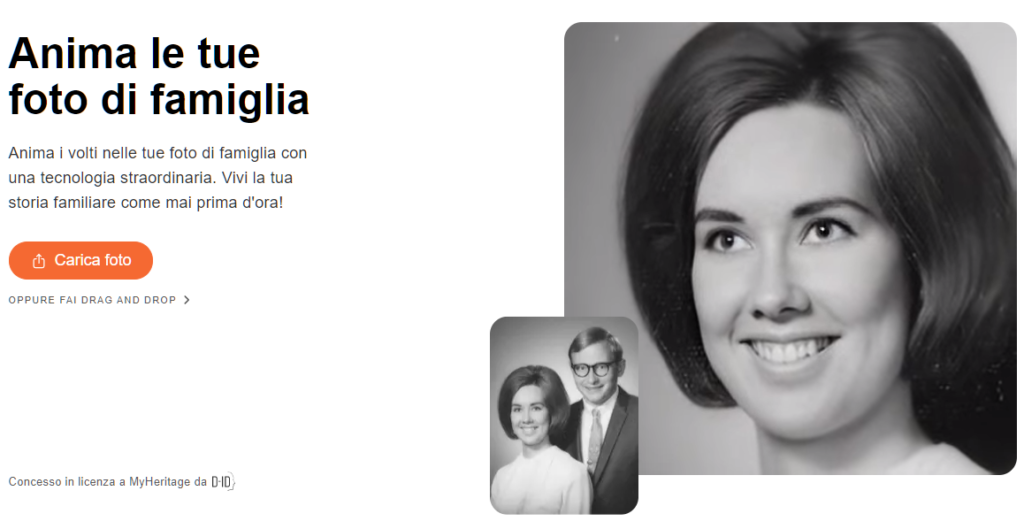

Deep Nostalgia, riporta in vita foto d’epoca

Riportare in vita foto d’epoca. Questo è il nuovo servizio pubblicato da MyHeritage che sicuramente troverà eco nei social e che susciterà la curiosità di molti appassionati.

Andando sul sito https://www.myheritage.it/deep-nostalgia è possibile, dopo una registrazione gratuita, caricare una qualsiasi immagine di un volto umano (anche di nostri cari defunti…) per vederne una piccola animazione online.

Se tale funzionalità ha ovviamente l’obiettivo di attirare clienti al sito che riunisce appassionati di genealogia (oltre a possibili altre finalità di data recording di immagini caricate) in realtà porta alla luce del pubblico generalista una importante start-up che in questi ultimi anni ha studiato e implementato importanti algoritmi basati sul face-recognition.

Prima di introdurla, cercherò di fare una breve sintesi su un argomento sicuramente molto vasto (sia tecnicamente che eticamente) a cui però dobbiamo in qualche modo approcciarci anche per raggiungere una certa consapevolezza dei sistemi che usiamo quotidianamente.

Face recognition e privacy

Con la diffusione sempre più capillare delle tecniche di face recognition applicate nei settori più disparati, si sta portando alla luce una problematica legata alla conservazione e all’utilizzo di questi dati biometrici conservati dalle società fornitrici di servizi che, se non utilizzati in modo appropriato, possono diventare materiale utile per il tracciamento e il furto della nostra identità.

Per sottolineare l’importanza della conservazione di tali dati, basti immaginare che, a differenza di altri sistemi di controllo di accesso, in caso di violazione e compromissione dei nostri dati biometrici, questi non non possono essere modificati o azzerati, come avverrebbe in caso di semplici password.

Ma pensiamo anche i servizi non prettamente legati all’autenticazione, come ad esempio le applicazioni di smart-cities, traffic monitoring, telecamere di video-sorveglianza, ecc.

Tutte queste fonti di registrazione riversano il loro flusso dati in archivi digitali che, giorno per giorno, conterranno migliaia, anzi milioni, di dati biometrici di persone che sono state – a volte addirittura a loro insaputa – registrate (e quindi potenzialmente identificabili).

Considerato questo contesto, le varie policy internazionali (fra cui il nostro GDPR) stanno includendo maggiore tutela e consapevolezza per questa tipologia di dati, classificandoli in sezioni specifiche all’interno dei propri regolamenti, cercando di dare massima tutela proprio a causa della natura fortemente personale di tali informazioni.

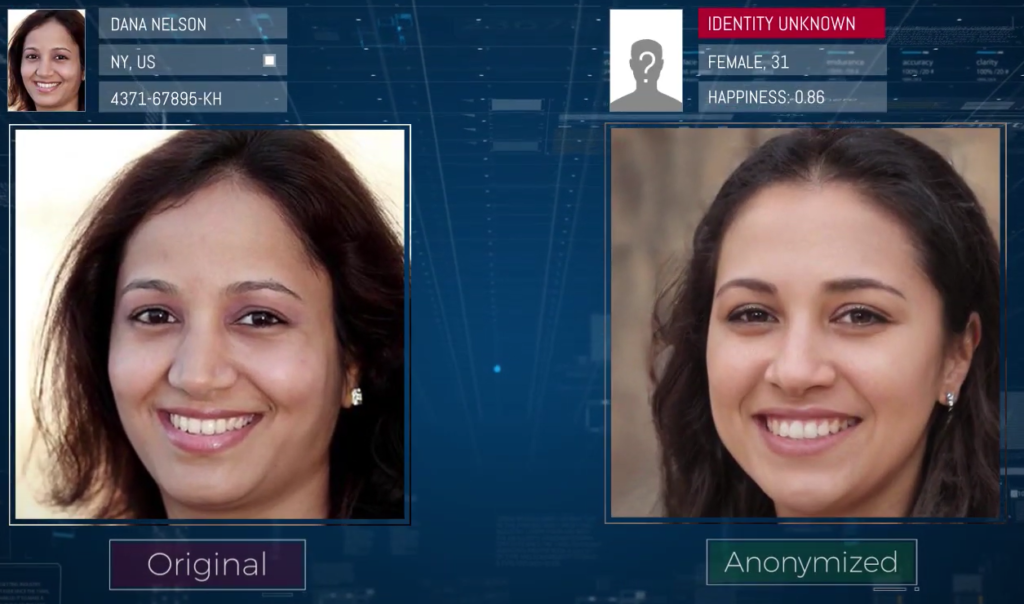

Tra le varie società che operano in questo contesto, troviamo una società israeliana chiamata D-ID che ha concentrato il suo core-business proprio sullo studio di algoritmi di anonimizzazione biometrica e in particolare implementando tecniche di de-Identification basate sul face-recognition.

A differenza delle altre tecniche generalmente utilizzate in tal senso, che vanno ad operare una vera e propria alterazione o cancellazione dei volti registrati (utilizzando le tecniche di blurring, pixelation, face swapping, deterioration, quality reduction and K-SAME), la società D-ID ha concepito un algoritmo che consente di mantenere intatta la riconoscibilità e l’espressività dei volti andando, al tempo stesso, a modificare solo quelle specifiche features che vengono utilizzate dagli algoritmi di face-recognition per distinguere le immagini e ricondurle alla nostra identità, producendo di fatto un’anonimizzazione digitale.

Questo approccio può essere utilizzato anche per generare degli avatar che, pur garantendo una verosimiglianza con il nostro volto originale, non consentono ai software di dedurre le nostre informazioni biometriche, la nostra etnia, provenienza o qualsiasi altra informazione riconducibile alla nostra identità (personally identifiable information).

D-ID è una delle realtà che è sotto i riflettori sia perché conta al proprio interno un advisory board di nomi illustri che possono indirizzare opportunità verso lo sviluppo di nuovi algoritmi, sia perché tali applicazioni troveranno sempre più integrazione all’interno della nostra quotidianità digitale e reale.

Per approfondire: https://www.deidentification.co/

Convegno OpenLAB 2019 al Politecnico di Bari

Ti sei perso l’evento OpenLAB 2019 che si è tenuto al Politecnico di Bari ?

Nessun problema!

In questo video potrai riascoltare alcuni interventi di alcuni relatori come il Prof. Cesare Verdoscia (Politecnico di Bari), Giampaolo Parravicini (AMD), Prof. Vitoantonio Bevilacqua (Politecnico di Bari), Roberto Madonna (Graitec) e ovviamente il mio 🙂

Io ho cercato di affrontare alcune nuove tecnologie che si stanno sviluppando nella computer grafica come il RayTracing e l’Intelligenza Artificiale, portando alcuni casi studio sviluppati in ambito universitario internazionale.

Se hai delle domande e dei dubbi, non esitare a contattarmi 🙂

Intervista convegno OpenLab 2019

In questo video è possibile rivedere una mia intervista a seguito del convegno OpenLAB 2019 tenutosi presso il Politecnico di Bari in cui si è parlato di Tecnologie 3D, BIM, Cinema 4D e Intelligenza Artificiale.